Neuronska mreža širenja unapred

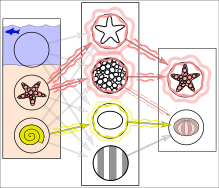

Pojednostavljeni primer obuke neuronske mreže u otkrivanju objekata: Mreža je obučena pomoću više slika za koje je poznato da prikazuju morske zvezde i morske ježeve, koji su u korelaciji sa „čvorovima“ koji predstavljaju vizuelne karakteristike. Morske zvezde se poklapaju sa prstenastom teksturom i zvezdastim obrisom, dok većina morskih ježeva odgovara prugastoj teksturi i ovalnom obliku. Međutim, primer morskog ježa sa prstenastom teksturom stvara slabo ponderisanu povezanost između njih.

Naknadno pokretanje mreže na ulaznoj slici (levo):[1] Mreža ispravno detektuje morsku zvezdu. Međutim, slabo ponderisana povezanost između prstenaste teksture i morskog ježa takođe daje slab signal ovom poslednjem iz jednog od dva srednja čvora. Pored toga, školjka koja nije bila uključena u obuku daje slab signal za ovalni oblik, što takođe rezultira slabim signalom za izlaz morskog ježa. Ovi slabi signali mogu rezultirati lažno pozitivnim rezultatom za morskog ježa.

U stvarnosti, teksture i obrisi ne bi bili predstavljeni pojedinačnim čvorovima, već povezanim obrascima pondera više čvorova.

U stvarnosti, teksture i obrisi ne bi bili predstavljeni pojedinačnim čvorovima, već povezanim obrascima pondera više čvorova.

Neuronska mreža širenja unapred (енгл. feedforward neural network, FNN) je jedan od dva široka tipa veštačke neuronske mreže, koju karakteriše pravac toka informacija između njenih slojeva.[2] Njegov tok je jednosmeran, što znači da informacije u modelu teku samo u jednom pravcu — napred — od ulaznih čvorova, preko skrivenih čvorova (ako ih ima) i do izlaznih čvorova, bez ikakvih ciklusa ili petlji,[2] za razliku od rekurentnih neuronskih mreža,[3] koje imaju dvosmerni tok. Moderne mreže unapred su obučene korišćenjem metode propagacije unazad[4][5][6][7][8] i kolokvijalno se nazivaju „vanila” neuronske mreže.[9]

Hronologija[уреди | уреди извор]

- Godine 1958, višeslojnu mrežu perceptrona, koja se sastoji od ulaznog sloja, skrivenog sloja sa randomizovanim ponderima koji nisu učili, i izlaznog sloja sa vezama za učenje, već je predstavio Frenk Rozenblat u svojoj knjizi Perceptron.[10][11][12] Ova mašina za ekstremno učenje[13][12] još nije bila mreža za duboko učenje.

- Godine 1965, Aleksej Grigorevič Ivahnjenko i Valentin Lapa, objavili su prvu mrežu sa dubokim učenjem, koja još nije koristila stohastički gradijentni spuštanja, u to vreme nazvanu Grupni metod rukovanja podacima.[14][15][12]

- Godine 1967, mreža sa dubokim učenjem, koristeći stohastički gradijentni spusta po prvi put bila je u stanju da klasifikuje nelinearno odvojive klase šablona, kao što je izvestio Šuniči Amari.[16] Amarijev učenik Sajto je sproveo kompjuterske eksperimente, koristeći petoslojnu mrežu širenja unapred sa dva sloja učenja.

- Godine 1970, je finski istraživač Sepo Linajnma[4][17][12] po prvi put objavio modernu metodu propagacije unazad, efikasnu primenu nadgledanog učenja zasnovanog na lančanim pravilima.[18][19] Sam termin (tj. „greške propagiranja unazad“) je koristio sam Rozenblat,[11] ali on nije znao kako da ga implementira[12] iako je kontinuirani prekurzor propagacije unazad već korišćen u kontekstu teorije upravljanja u radu Henrija DŽ. Kelija 1960. godine.[5][12] Poznat je i kao reverzni način automatske diferencijacije.

- Godine 1982, propagacija unazad je primenjena na način koji je postao standard, po prvi put od strane Pola Verbosa.[7][12]

- Godine 1985, eksperimentalnu analizu tehnike sproveli su Dejvid E. Rumelhart et al.[8] U narednim decenijama napravljena su mnoga poboljšanja u pristupu.[12]

- Godine 1987, koristeći stohastički gradijentni spust unutar (široke 12-slojne nelinearne) mreže unapred, Metju Brend ju je obučio da reprodukuje logičke funkcije netrivijalne dubine kola, koristeći male serije nasumičnih ulazno/izlaznih uzoraka. On je, međutim, zaključio da je na hardveru (sub-megaflop računarima) koji je bio dostupan u to vreme to bilo nepraktično, i predložio je korišćenje fiksnih nasumičnih ranih slojeva kao ulaznog heša za jedan sloj koji se može menjati.[20]

- Tokom 1990-ih, Vladimir Vapnik i njegove kolege razvili su (mnogo jednostavniju) alternativu korišćenju neuronskih mreža, iako još uvek srodnu[21] mašini potpornih vektora. Pored izvođenja linearne klasifikacije, oni su bili u stanju da efikasno izvrše nelinearnu klasifikaciju koristeći ono što se naziva trik jezgra, koristeći visokodimenzione prostore karakteristika.

- Godine 2003, interesovanje za mreže za širenje unazad se vratilo zbog uspeha dubokog učenja koje je Džošua Bengio sa koautorima primenio na modelovanje jezika.[22]

- Godine 2017, uvedene su moderne transformatorske arhitekture.[23]

Reference[уреди | уреди извор]

- ^ Ferrie, C.; Kaiser, S. (2019). Neural Networks for Babies. Sourcebooks. ISBN 1492671207.

- ^ а б Zell, Andreas (1994). Simulation Neuronaler Netze [Simulation of Neural Networks] (на језику: German) (1st изд.). Addison-Wesley. стр. 73. ISBN 3-89319-554-8.

- ^ Schmidhuber, Jürgen (2015-01-01). „Deep learning in neural networks: An overview”. Neural Networks (на језику: енглески). 61: 85–117. ISSN 0893-6080. PMID 25462637. S2CID 11715509. arXiv:1404.7828

. doi:10.1016/j.neunet.2014.09.003.

. doi:10.1016/j.neunet.2014.09.003.

- ^ а б Linnainmaa, Seppo (1970). The representation of the cumulative rounding error of an algorithm as a Taylor expansion of the local rounding errors (Masters) (на језику: фински). University of Helsinki. стр. 6–7.

- ^ а б Kelley, Henry J. (1960). „Gradient theory of optimal flight paths”. ARS Journal. 30 (10): 947–954. doi:10.2514/8.5282.

- ^ Rosenblatt, Frank. x. Principles of Neurodynamics: Perceptrons and the Theory of Brain Mechanisms. Spartan Books, Washington DC, 1961

- ^ а б Werbos, Paul (1982). „Applications of advances in nonlinear sensitivity analysis” (PDF). System modeling and optimization. Springer. стр. 762–770. Архивирано (PDF) из оригинала 14. 4. 2016. г. Приступљено 2. 7. 2017.

- ^ а б Rumelhart, David E., Geoffrey E. Hinton, and R. J. Williams. "Learning Internal Representations by Error Propagation Архивирано на сајту Wayback Machine (13. октобар 2022)". David E. Rumelhart, James L. McClelland, and the PDP research group. (editors), Parallel distributed processing: Explorations in the microstructure of cognition, Volume 1: Foundation. MIT Press, 1986.

- ^ Hastie, Trevor. Tibshirani, Robert. Friedman, Jerome. The Elements of Statistical Learning: Data Mining, Inference, and Prediction. Springer, New York, NY, 2009.

- ^ Rosenblatt, Frank (1958). „The Perceptron: A Probabilistic Model For Information Storage And Organization in the Brain”. Psychological Review. 65 (6): 386–408. CiteSeerX 10.1.1.588.3775

. PMID 13602029. S2CID 12781225. doi:10.1037/h0042519.

. PMID 13602029. S2CID 12781225. doi:10.1037/h0042519.

- ^ а б Rosenblatt, Frank (1962). Principles of Neurodynamics. Spartan, New York.

- ^ а б в г д ђ е ж Schmidhuber, Juergen (2022). „Annotated History of Modern AI and Deep Learning”. arXiv:2212.11279

[cs.NE].

[cs.NE].

- ^ Huang, Guang-Bin; Zhu, Qin-Yu; Siew, Chee-Kheong (2006). „Extreme learning machine: theory and applications”. Neurocomputing. 70 (1): 489–501. CiteSeerX 10.1.1.217.3692

. S2CID 116858. doi:10.1016/j.neucom.2005.12.126.

. S2CID 116858. doi:10.1016/j.neucom.2005.12.126.

- ^ Ivakhnenko, A. G. (1973). Cybernetic Predicting Devices. CCM Information Corporation.

- ^ Ivakhnenko, A. G.; Grigorʹevich Lapa, Valentin (1967). Cybernetics and forecasting techniques. American Elsevier Pub. Co.

- ^ Amari, Shun'ichi (1967). „A theory of adaptive pattern classifier”. IEEE Transactions. EC (16): 279-307.

- ^ Linnainmaa, Seppo (1976). „Taylor expansion of the accumulated rounding error”. BIT Numerical Mathematics. 16 (2): 146–160. S2CID 122357351. doi:10.1007/bf01931367.

- ^ Rodríguez, Omar Hernández; López Fernández, Jorge M. (2010). „A Semiotic Reflection on the Didactics of the Chain Rule”. The Mathematics Enthusiast. 7 (2): 321–332. S2CID 29739148. doi:10.54870/1551-3440.1191

. Приступљено 2019-08-04.

. Приступљено 2019-08-04.

- ^ Leibniz, Gottfried Wilhelm Freiherr von (1920). The Early Mathematical Manuscripts of Leibniz: Translated from the Latin Texts Published by Carl Immanuel Gerhardt with Critical and Historical Notes (Leibniz published the chain rule in a 1676 memoir) (на језику: енглески). Open court publishing Company. ISBN 9780598818461.

- ^ Matthew Brand (1988) Machine and Brain Learning. University of Chicago Tutorial Studies Bachelor's Thesis, 1988. Reported at the Summer Linguistics Institute, Stanford University, 1987

- ^ R. Collobert and S. Bengio (2004). Links between Perceptrons, MLPs and SVMs. Proc. Int'l Conf. on Machine Learning (ICML).

- ^ Bengio, Yoshua; Ducharme, Réjean; Vincent, Pascal; Janvin, Christian (март 2003). „A neural probabilistic language model”. The Journal of Machine Learning Research. 3: 1137—1155.

- ^ Geva, Mor; Schuster, Roei; Berant, Jonathan; Levy, Omer (2021). „Transformer Feed-Forward Layers Are Key-Value Memories”. Proceedings of the 2021 Conference on Empirical Methods in Natural Language Processing. стр. 5484—5495. S2CID 229923720. doi:10.18653/v1/2021.emnlp-main.446.